第二代Transformer引擎:結合了Blackwell Tensor Core技術和TensorRT-LLM和NeMo Megatron框架中的英偉達先進動態范圍管理算法,Blackwell將通過新的4位浮點AI支持雙倍的計算和模型大小推理能力。

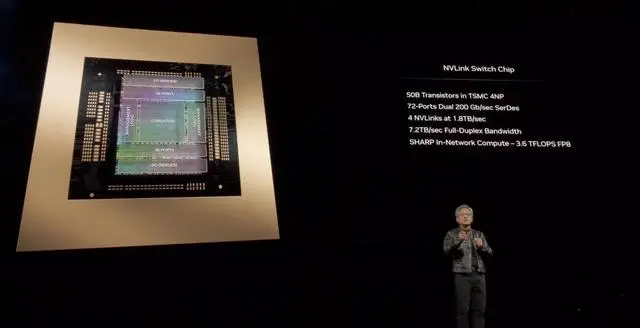

第五代NVlink:為提高數萬億參數和混合專家AI模型的性能,最新一代英偉達NVlink為每個GPU提供了突破性的1.8TB/s雙向吞吐量,確保最復雜LLM之間多達576個GPU之間的無縫高速通信。

RAS引擎:Blackwell支持的GPU包含一個專用引擎,實現可靠性、可用性和服務性。此外,Blackwell架構還增加了芯片級功能,利用基于AI的預防性維護進行診斷和預測可靠性問題。這可以最大限度地延長系統正常運行時間,并提高大部署規模AI的彈性,使其能連續運行數周甚至數月,并降低運營成本。

安全人工智能:先進的機密計算功能可在不影響性能的情況下保護AI模型和客戶數據,并支持新的本機接口加密協議,這對于醫療保健和金融服務等隱私敏感行業至關重要。

解壓縮引擎:專用解壓縮引擎支持最新格式,加快數據庫查詢,提供數據分析和數據科學的最高性能。未來幾年,在企業每年花費數百億美元的數據處理方面,將越來越多地由GPU加速。

Blackwell GPU體積龐大,將兩個單獨制造的晶粒組合成一個由臺積電制造的芯片。它還將作為一款名為GB200 NVlink 2的整個服務器提供,該服務器結合了72個Blackwell GPU和其他旨在訓練AI模型的英偉達部件。

亞馬遜、谷歌、微軟和甲骨文將通過云服務提供對GB200的訪問。GB200將兩個B200 Blackwell GPU與一個基于Arm的Grace CPU配對。英偉達表示,亞馬遜網絡服務將構建一個包含20000個GB200芯片的服務器集群。

英偉達沒有提供新款GB200或其使用系統的成本。據分析師估計,英偉達基于Hopper的H100芯片成本在2.5萬至4萬美元之間,而整個系統的成本高達20萬美元。

英偉達推理微服務

英偉達還宣布,將在其英偉達企業軟件訂閱中添加一款名為NIM(英偉達推理微服務)的新產品。NIM讓使用較舊的英偉達GPU進行推理(或運行AI軟件的過程)變得更加簡單,并允許公司繼續使用其已經擁有的數億個英偉達GPU。與新AI模型的初始訓練相比,推理所需的計算能力較少。對于那些希望運行自己的AI模型,而不是從OpenAI等公司購買AI結果作為服務的企業來說,NIM無疑是他們的得力助手。

英偉達的策略是吸引購買基于英偉達的服務器的客戶注冊英偉達企業版,每個GPU每年的許可費為4500美元。

英偉達將與微軟或Hugging Face等AI公司合作,確保他們的AI模型能夠在所有兼容的英偉達芯片上運行。隨后,開發者可以使用NIM在自有服務器或基于云端的英偉達服務器上高效運行模型,無需繁瑣的配置過程。

“在我原本調用OpenAI的代碼中,我只需替換一行代碼,將其指向從英偉達獲取的NIM即可。”Das說道。

英偉達表示,該軟件還將助力AI在配備GPU的筆記本電腦上運行,而非僅限于云端服務器。